מסטטיסטיקה ל-AI: ההיסטוריה של הטרנספורמר שמאחורי ChatGPT

מ-RNN דרך LSTM ועד למאמר המהפכני של נועם שזיר ● כך מסע של 50 שנה הוביל לרגע שבו מכונות החלו להבין משמעות ולא רק לחשב הסתברויות

המסע להבנת שפה טבעית על ידי מכונות התחיל לפני יותר מחמישים שנה, הרבה לפני שהמונח "בינה מלאכותית ג'נרטיבית" הפך לחלק מהשיח היומיומי.

בשנות השישים והשבעים נעשה ניסיון לגרום למחשבים לזהות מילים ולנתח משפטים בשיטות סטטיסטיות פשוטות שהתבססו על שכיחות. המערכות חישבו הסתברויות, אך לא הצליחו להבין משמעות, אירוניה או הקשר רחב. החוקרים באותה תקופה האמינו שעם מספיק נתונים וכוח חישוב, הבעיה תיפתר מאליה. אבל המציאות הייתה מורכבת יותר. רק בעשורים האחרונים, עם כניסת רשתות נוירונים מלאכותיות ויכולת חישוב גבוהה, החל להתקרב הרגע שבו מכונה מסוגלת לנסח משפט באופן כמעט אנושי. אבל לפני שנולד הטרנספורמר (Transformer), הדרך הייתה מלאת מגבלות, טעויות ושיטות שלא הצליחו לפתור את הקושי המרכזי – הבנת משמעות המשפט בשלמותו.

מה רע בשפה שמבוססת רק על סטטיסטיקה

המודלים הראשונים ניתחו מילים על בסיס הופעתן ולא על בסיס משמעותן. אם המילים 'גשם' ו'עננים' הופיעו יחד לעיתים קרובות, המערכת הסיקה קשר ביניהן, אך לא ידעה להסביר אותו. כאשר הופיע משפט כמו "ירד עליו גשם של טענות", המחשב פירש זאת כמשהו מטאורולוגי. הבנת שפה אנושית מחייבת ניתוח הקשר, כוונה וסרקזם – דברים שהשיטות הסטטיסטיות לא הצליחו ליישם. הן היו מהירות, אך לא חכמות. המסקנה הייתה ברורה: כדי להתקדם, יש לזנוח את הגישה הסטטיסטית לטובת גישה קוגניטיבית יותר. הקהילה המדעית הבינה שצריך לחקות לא רק את התוצר הלשוני, אלא את התהליך המנטלי עצמו.

המודלים הראשונים ניתחו מילים על בסיס הופעתן ולא על בסיס משמעותן. כאשר הופיע משפט כמו "ירד עליו גשם של טענות", המחשב פירש זאת כמשהו מטאורולוגי

הבקבוק הצר של העיבוד הסדרתי

רשתות RNN (ר"ת Recurrent Neural Networks – רשתות נוירונים רקורנטיות) סימנו את תחילת המעבר להבנה ממוחשבת מתקדמת יותר. הן עיבדו משפטים שלב אחר שלב, מילה אחר מילה, בדיוק כמו שאדם קורא משמאל לימין. בהמשך הופיעו וריאציות משופרות כמו LSTM (ר"ת Long Short Term Memory – זיכרון לטווח קצר וארוך) ו-GRU (ר"ת Gated Recurrent Unit – יחידת רקורנט מבוקרת). הן אפשרו שמירה חלקית של מידע לאורך זמן והיוו שיפור משמעותי. אולם גם אם המשפט היה ארוך, המודל התקשה לזכור את תחילתו כשהגיע לסופו. כמו אדם שמנסה להבין פסקה תוך קריאה מבלי להרים את הראש, עומס המידע גרם לירידה ביכולת ההבחנה. בנוסף, העיבוד היה איטי כי נעשה באופן טורי – כל מילה חייבה לחכות לקודמתה. זה מנע מהמכונות לפתח הבנה עמוקה של המשפט, והפך את האימון למאתגר במיוחד.

כשניסו להבין שפה כמו תמונה

רשתות CNN (ר"ת Convolutional Neural Networks – רשתות נוירונים קונבולוציוניות), שנוצרו במקור לניתוח תמונות, יושמו גם בטקסט. הן זיהו תבניות מקומיות, כמו שמזהים צורות בפיקסלים. הדבר סייע לניתוח תחביר ולזיהוי מבני משפט, אך לא סיפק הבנה של המשמעות הרחבה. המודלים הסתכלו על "חלונות" מילים מצומצמים ולא יכלו לראות את "התמונה המלאה". משפט כמו "ההחלטה שהתקבלה אתמול תשפיע על העתיד" דרש הבנה רחבה, אך המודל התייחס רק לחלקיו הקרובים. השיטה הייתה יעילה לזיהוי דפוסים חוזרים, אך לא להבנת משמעות סמנטית מורכבת. למרות שיפור בביצועים, אף אחת מהשיטות הללו לא פתרה את הליבה: להבין את המשפט כיחידה אחת, עם כל הקשריו ותלויותיו הפנימיות.

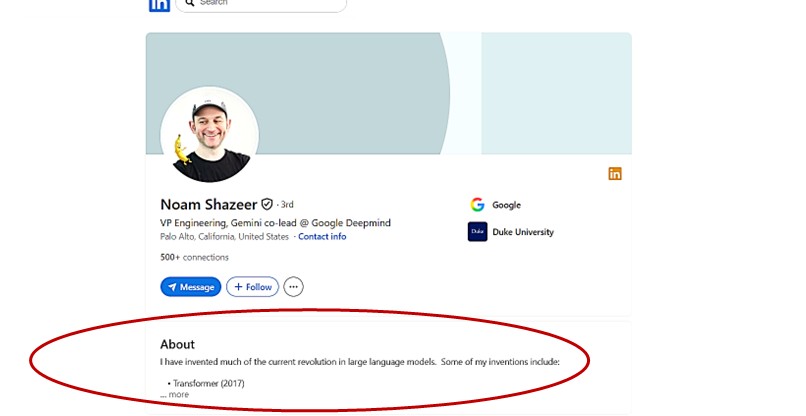

החוקר נועם שזיר, סמנכ"ל הנדסה, מנהל שותף של ג'מיני ב-גוגל דיפ מיינד. צילום: לכידת מסך מחשבון הלינקדאין של שזיר

המשפט שעשה היסטוריה: "Attention Is All You Need"

בשנת 2017 פורסם מאמר שנשא שם זה, ואחד ממחבריו הוא נועם שזיר, חוקר יהודי אמריקני שעבד אז בגוגל (Google). הוא הציג גישה מהפכנית: במקום לעבד את המשפט בצורה סדרתית, אפשר לבחון אותו כולו במקביל.

מנגנון ה-Attention (הקשב) מאפשר למודל להעריך אילו מילים חשובות יותר זו ביחס לזו, בדיוק כמו שאנחנו מפנים תשומת לב לחלקים שונים במשפט. לדוגמה, במשפט "הילד שתה את המים כי הוא היה צמא", המערכת מזהה ש-"הוא" מתייחס ל-"הילד" ולא ל-"מים". היכולת להתייחס לכל חלקי המשפט בו-זמנית ביטלה את מגבלת הזיכרון הסדרתי והאיצה את האימון באופן דרמטי. מכאן נולדה ארכיטקטורת הטרנספורמר, שהפכה לבסיס של מודלים מתקדמים כמו GPT, BERT ו-ג'מיני (Gemini). השינוי לא היה רק טכני – הוא היה תפישתי. המאמר הפך לאחד המצוטטים ביותר בהיסטוריה של למידת מכונה.

היום כבר לא מנסים להבין מילים, אלא להבין כוונה

הטרנספורמר אפשר למכונות לדמות תהליך חשיבה לזה של בני האדם: לראות את המשפט בשלמותו, לפרש כוונות ולהסיק מסקנות. כיום, מודלים מבוססי טרנספורמר משמשים לכתיבת תוכן, לתרגום אוטומטי, לניתוח רגשות, למתן המלצות ואפילו לתמיכה בהחלטות עסקיות. הם מסוגלים לכתוב קוד, לסכם ישיבות, לנתח חוזים ולהבין שאלות מורכבות בעשרות שפות.

ההתקדמות בתחום לא נעצרה – החוקרים בוחנים כיצד לשלב חשיבה לוגית, למידה עצמאית ואמפתיה. הם חוקרים דרכים לגרום למודלים להבין לא רק מה נאמר, אלא גם מה לא נאמר – את הרמזים, את השתיקות, את המשתמע. עדיין לא ידוע מה תהיה הפריצה הבאה, אך ברור שהטרנספורמר הפך לנקודת מפנה היסטורית. המכונות התחילו להבין, לא רק לחשב.

הכותב הוא יועץ טכנולוגי לארגונים, בעיקר בתחום האשראי החוץ בנקאי

תגובות

(0)