למה מודלי AI מתקדמים נוטים יותר להזיות?

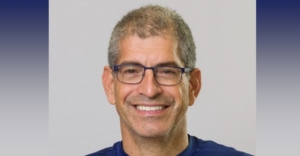

בניגוד למה שניתן לחשוב, בדיקה של OpenAI העלתה שמודלים מתקדמים יותר של בינה מלאכותית כוללים יותר הזיות ● יוני נאמן מ-Melingo AI מסביר למה זה קורה

המוסכמה העקרונית בעולם התוכנה, ובעולם הטכנולוגיה בכלל, היא שגרסאות מאוחרות יותר אמורות לשפר תוכנה, לא להפוך אותה לגרועה יותר. אף על פי שלפעמים מתרחשות קטסטרופות (אני מסתכל עליכם, סונוס), בגדול – זה המצב. אולם, מתוך מסמך פנימי של OpenAI, שהתפרסם לפני כשבועיים, עולה שמודלים חדישים יותר של החברה, כמו o3-mini, הם, למעשה, פחות טובים ממודלים קיימים, כמו o1, והוזים יותר מקודמיהם. הסיבה לכך היא, ככל הנראה, אנומליות ביכולות ההיקש – או מה שמכונה באנגלית Deep Reasoning.

המודלים החדשים זכו לביקורות חיוביות ממאמצים מוקדמים, וניכר שהם מצטיינים במשימות כמו קידוד, מדע ומתמטיקה ומפגינים תפיסה ויזואלית ויכולות ניתוח חזקות. אלא שבדיקות פנימיות של OpenAI העלו שמודלי o3 ו-o4-mini, שאמורים להיות יותר חסיני הזיות, הוזים יותר ממודלים קודמים כמו o1 או o3-mini, וכן מ-GPT-4o, שהוא מודל ללא היקש. החלק המוזר הוא שאנשי החברה לא באמת יודעים למה זה קורה. אחד הסוקרים תיאר את המצב כסכין משוננת: בחלקים מסוימים הבינה המלאכותית מציגה יכולות כמעט על אנושיות, ובקטעים אחרים היא נופלת להזיות.

במסמך הטכני כותבים החוקרים כי "נדרש מחקר נוסף" כדי להבין למה ההזיות מחמירות, ככל שהיא מרחיבה את המודלים שלה. טענות כאלה, אגב, התחילו להישמע גם לגבי המודלים החדשים של ג'מיני מבית גוגל.

כמה הוזה כל מודל?

אנשי OpenAI מצאו ש-o3 הזה ב-33% מהמקרים בשאלות על PersonQA – מדד פנימי של החברה שבוחן את דיוק הידע על אישים. זה בערך כפליים מכמות ההזיות של מודלי היקש קודמים, כמו o1 ו-o3-mini, שהזו רק ב-16% וב-14.8% מהמקרים, בהתאמה. ל-o4-mini היו תוצאות גרועות אף יותר – הוא הזה ב-48%. במבחן SimpleQA, אותו מודל הזה ב-79% מהמקרים, o3 הזה ב-51% מהמקרים ו-o1 – "רק" ב-44% מהם. כלומר, הוא יותר יציב מיורשיו המתוכננים. באשר ל-o3 – שיעור ההזיות הופך אותו למודל פחות יעיל ממה שהוא אמור להיות. אחת ההזיות המוזרות שלו היא יצירת קישורים לאתרים שלא קיימים.

חקירה חיצונית שבדקה את הממצאים של OpenAI הגיעה למסקנות דומות, וההשערה של ניק צ'אודהורי, חוקר ב-Transluce ועובד לשעבר ב-OpenAI, היא שהלמידה החיזוקית הנוכחית עלולה להגביר בעיות קיימות, במקום לפתור או לפצות עליהן.

ראוי לציין שטכנולוגיית ההיקש במודלי השפה הגדולים היא "אופנה" שהתחילה בשנה החולפת, אחרי שהתגלה שטכניקות אחרות לשיפור מודלים קיימים הניבו תוצאות ירודות. יכולת ההיקש – או Deep Reasoning, כאמור – משפרת את ביצועי המודלים במגוון משימות, מבלי להזדקק למשאבי מחשוב ומידע עצומים בשלב האימון. אבל, כפי שנראה כרגע, הטכנולוגיה הזו יצרה לא רק קפיצה ביכולות, אלא לעתים גם יותר הזיות.

אלברט איינשטיין. צילום: ארתור מסה

הבינה המלאכותית חסרה בידע על אלברט איינשטיין

יוני נאמן, המייסד וסמנכ"ל הטכנולוגיות של Melingo AI, התייחס למחקר של OpenAI ואמר כי "כמודלי היקש, o3 ו-o4-mini לא פולטים תשובה מיד, אלא מייצרים 'שרשרת מחשבה (Chain of Thought)' – הם מפרשים את הבקשה, שואלים את עצמם מה נדרש ומתכננים את הדרך לפתרון".

לדבריו, "למודלים אלה יש יתרונות בתחומי הלוגיקה, המתמטיקה וכתיבת הקוד, אך חסרונות בזמן התגובה, בעלויות ומסתבר עכשיו שבמקרים מסוימים, גם בירידה בדיוק של עובדות בסיסיות".

נאמן פירט עוד על הבדיקה: "היא הייתה מול בנצ'מארק בשם PersonQA – מאגר שאלות עובדתיות קצרות על אישים מפורסמים, לדוגמה: מתי נולד אלברט איינשטיין? ובאיזו אוניברסיטה כתבה מארי קירי את עבודת הדוקטורט שלה? במבחן זה, המודלים החדשים הראו שיעור טעויות גבוה מאוד (48%-33% מהתשובות כללו שגיאות) לעומת מודלים קודמים – הן מודלי היקש והן מודלים רגילים, שבהם שיעור ההזיות היה נמוך יותר בממוצע ועמד על כ-15%. אם כי יש לציין שגם 15% הזיות הוא שיעור גבוה מדי".

מארי קירי. צילום: ShutterStock

לדבריו, "חלק משמעותי מהבעיה נעוץ בכך ששאלות כאלה דורשות שליפה מדויקת של עובדה קצרה, למשל תאריך לידה, וזה לא התחום החזק של מודלי GenAI – ובפרט לא של מודלי היקש, שמתוכננים לבצע משימות מורכבות יותר כמו הסקת מסקנות, כתיבת קוד או ניתוח טקסטים. ייתכן שהשוואה שכזו בודקת אותם במטלה שלא מתאימה להם, ולכן תוצאותיה מוטות".

מדוע נגרמה הירידה, דווקא בדור חדש יותר?

"יש לכך כמה תשובות אפשריות:

התמקצעות על חשבון גמישות – ככל שמודלים משתכללים, הם נעשים טובים יותר במה שהם תוכננו לעשות, למשל תכנות, אך פחות טובים במשימות כלליות כמו שליפת עובדות קצרות.

היצע מוגבל של מידע – המודלים מאומנים על טקסטים. כמות המידע האיכותי והמהימן היא מוגבלת וכמות המידע המהימן ברשת לא גדלה בקצב שמדביק את הצורך. התוצאה: לפעמים מאמנים מודלים על מידע פחות אמין, או על טקסטים שיש חשד שנוצרו בעצמם על ידי AI – מה שנקרא תוכן מג'ונרט, וזה יוצר בעיית סיבוביות והטיות.

בעיית המשוב האנושי – חלק מהאימון נעשה בשיטה של Reinforcement Learning from Human Feedback (חיזוק למידה על ידי משוב אנושי), אבל כשהמודל עונה בביטחון, גם כשהוא לא מדויק – הבודקים נוטים לאשר את התשובה, וכך נוצר עיוות שמחזק שגיאות".

מה אפשר לעשות כדי למנוע ירידה באיכות התשובות בעתיד?

"המאבק בהזיות הוא הוא תחום שגם מאתגר וגם מביא לצורך בשוק, שעליו עונות חברות יישום AI כמו Melingo AI. כשמגיעים ליישום AI בשטח, אצל לקוחות, למשל בצ'טבוטים שמדמים אנשי מכירות בחנויות וירטואליות או מוקדנים בשירות לקוחות – אין מקום להזיות. הלקוחות לא יסלחו ל-38% הזיות, וגם לא ל-15%. אצלנו הדרישה היא ל-0% הזיות. יש הרבה אלמנטים במוצרים שלנו שמטפלים בכך. אציין את החשובים כאן:

Grounding (קרקוע) – המערכת משתמשת רק בנתונים מוסמכים של הלקוח. אם אין מידע – היא עונה שחסר מידע, במקום להמציא.

ניטור רציף – מערכות מדידה ודשבורדים ללקוחות מאפשרים מעקב על איכות התשובות, שביעות רצון המשתמשים וזיהוי מהיר של בעיות.

אימות ממודלים שונים – אם שני מודלים מסכימים על תשובה שהתקבלה ממקורות שונים, הסיכוי לטעות קטן בהרבה.

שאלות יזומות מצד המודל – הצ'טבוט לא רק מגיב, אלא גם יוזם. הוא מכווין את משתמש הקצה לנסח את דרישתו בצורה ברורה ושואל אותו שאלות ביוזמתו, כדי לדייק לעצמו את הבנת הצורך שלו, במיוחד כשהשאלה לא ברורה. הפתרון הזה עדיף על חשיבה עצמית של הצ'טבוט, בלי לערב את המשתמש.

בחינה וגמישות בבחירת מודלים – לא כל מודל מתאים לכל מטרה. כל מודל שאנחנו שוקלים להשתמש בו עובר בדיקות שמותאמות לצורך הספציפי, ולא רק לפי בנצ'מרקים כלליים, ואם צריך – מבוצע Fine-Tuning, שמתאים את התשובות לסוג השיח הדרוש ללקוח".

זה דיי דומה לשמאלנים , מרב "קדמה ופלורליזם" הם הוזים ופולטים שטויות.